RunPod AI

RunPod ist eine wirtschaftliche Cloud-Computing-Plattform für KI, die GPU-Dienste für die Entwicklung, das Training und die Skalierung von Machine-Learning-Modellen bietet.

Was ist RunPod?

RunPod ist eine Cloud-Computing-Plattform für KI und maschinelles Lernen. Sie bietet erschwingliche und zugängliche GPU-Cloud-Services, serverloses GPU-Computing und KI-Endpunkte ohne Leistungseinbußen. Benutzer können On-Demand-GPU-Instanzen erstellen, autoskalierende API-Endpunkte erstellen und benutzerdefinierte Modelle bereitstellen. Sie richtet sich an Startups, akademische Einrichtungen und Unternehmen.

Hauptfunktionen von RunPod

RunPod bietet eine kostengünstige und skalierbare Infrastruktur für die Entwicklung, das Training und die Bereitstellung von KI-Modellen. Es bietet GPU- und CPU-Ressourcen, serverloses Computing und benutzerfreundliche Bereitstellungstools, darunter sofortiger GPU-Zugriff, Autoskalierung, Job-Warteschlangen und Echtzeit-Analysen.

Anpassbare Umgebungen: Unterstützt benutzerdefinierte Container und über 50 vorkonfigurierte Vorlagen für verschiedene ML-Frameworks und Tools.

CLI und Hot-Reloading: Ein leistungsstarkes CLI-Tool ermöglicht die lokale Entwicklung mit Hot-Reloading für eine nahtlose Cloud-Bereitstellung.

Umfassende Analysen: Echtzeit-Nutzungsanalysen, detaillierte Metriken und Live-Logs zur Überwachung und Fehlersuche von Endpunkten und Workern.

Serverloses KI-Inferencing: Autoskalierende GPU-Worker verarbeiten täglich Millionen von Inferenzanfragen mit Cold-Start-Zeiten unter 250 ms.

Sofortiger GPU-Zugriff: Starten Sie GPU-Pods innerhalb von Sekunden, wodurch Cold-Boot-Zeiten für eine schnellere Entwicklung und Bereitstellung verkürzt werden.

Anwendungsfälle von RunPod

KI-Modelltraining: Führen Sie ressourcenintensives Training von Machine-Learning-Modellen auf Hochleistungs-GPUs durch.

Bereitstellung großer Sprachmodelle: Hosten und skalieren Sie große Sprachmodelle für Anwendungen wie Chatbots oder Textgenerierungsdienste.

Echtzeit-KI-Inferenz: Stellen Sie KI-Modelle für Echtzeit-Inferenz in Anwendungen wie Empfehlungssystemen oder Betrugserkennung bereit.

Computer Vision Processing: Führen Sie Bild- und Videoverarbeitungsaufgaben für Branchen wie autonome Fahrzeuge oder medizinische Bildgebung aus.

RunPod Vor- und Nachteile

- Benutzerfreundliche Oberfläche und Entwicklertools für eine schnelle Einrichtung und Bereitstellung

- Kostengünstiger GPU-Zugriff im Vergleich zu anderen Cloud-Anbietern

- Flexible Bereitstellungsoptionen mit On-Demand- und Serverless-Angeboten

- Einige Benutzer berichten über längere Verarbeitungszeiten im Vergleich zu anderen Plattformen für bestimmte Aufgaben

- Gelegentliche Schwankungen der Servicequalität, die von einigen langjährigen Benutzern gemeldet werden

- Eingeschränkte Rückerstattungsmöglichkeiten für Testbenutzer

RunPod FAQs

Was ist RunPod?

RunPod ist eine Cloud-Computing-Plattform für KI- und Machine-Learning-Anwendungen. Sie bietet GPU- und CPU-Ressourcen, serverloses Computing und Tools zur Entwicklung, zum Training und zur Skalierung von KI-Modellen.

Wie funktioniert die Preisgestaltung von RunPod?

RunPod verwendet ein Pay-as-you-go-Modell. GPU-Instanzen werden stündlich nach GPU-Typ abgerechnet; die serverlose Nutzung wird pro Anfrage abgerechnet. Es ist eine Mindestaufladung von 10 $ erforderlich.

Welche Arten von GPUs bietet RunPod?

RunPod bietet verschiedene GPUs an, darunter NVIDIA H100, A100, A40, L40, RTX A6000, RTX 4090, RTX 3090 und AMD MI300X. Preisgestaltung und Verfügbarkeit unterscheiden sich zwischen Secure Cloud und Community Cloud.

Was ist der Unterschied zwischen Secure Cloud und Community Cloud?

Secure Cloud bietet hochzuverlässige Infrastruktur in Rechenzentren der Enterprise-Klasse, während Community Cloud Peer-to-Peer-GPU-Computing zu möglicherweise niedrigeren Preisen, aber mit weniger garantierter Verfügbarkeit bietet.

Bietet RunPod eine kostenlose Testversion?

RunPod bietet derzeit keine kostenlosen Testversionen oder Credits an, aber Benutzer können mit einer Mindestaufladung von 10 $ beginnen.

Wie funktioniert das serverlose GPU-Angebot von RunPod?

Das serverlose GPU-Angebot von RunPod bietet Autoskalierung, Job-Warteschlangen und schnelle Cold-Start-Zeiten (unter 250 ms) und skaliert je nach Bedarf von 0 auf Hunderte von GPUs.

Welche Entwicklungstools bietet RunPod?

RunPod bietet eine Weboberfläche, ein CLI-Tool (runpodctl) und SDKs für GraphQL, JavaScript und Python. Die CLI unterstützt Hot-Reloading für die lokale Entwicklung.

Wie geht RunPod mit Sicherheit und Compliance um?

Die Rechenzentren von RunPod Secure Cloud erfüllen die Standards der Stufe 3 oder Stufe 4 und priorisieren Sicherheitsmaßnahmen. Kontaktieren Sie RunPod für spezifische Compliance-Details.

Interessiert an diesem Produkt?

Aktualisiert am 2025-03-27

AI Color Wheel ist ein KI-gestütztes Tool, mit dem Sie die perfekte Farbpalette für Ihre Logos, Illustrationen, Wireframes und andere Grafikdesigns finden können. Durch das Hochladen Ihres Flat Designs generiert das Tool automatisch Tausende von einzigartigen Farbvariationen, die auf klassischen und modernen Kunstbewegungen basieren. Es ist, als hätten Sie ein Team von Farbexperten an Ihrer Seite, die Ihnen Inspiration und Anleitung für Ihr nächstes kreatives Projekt bieten.

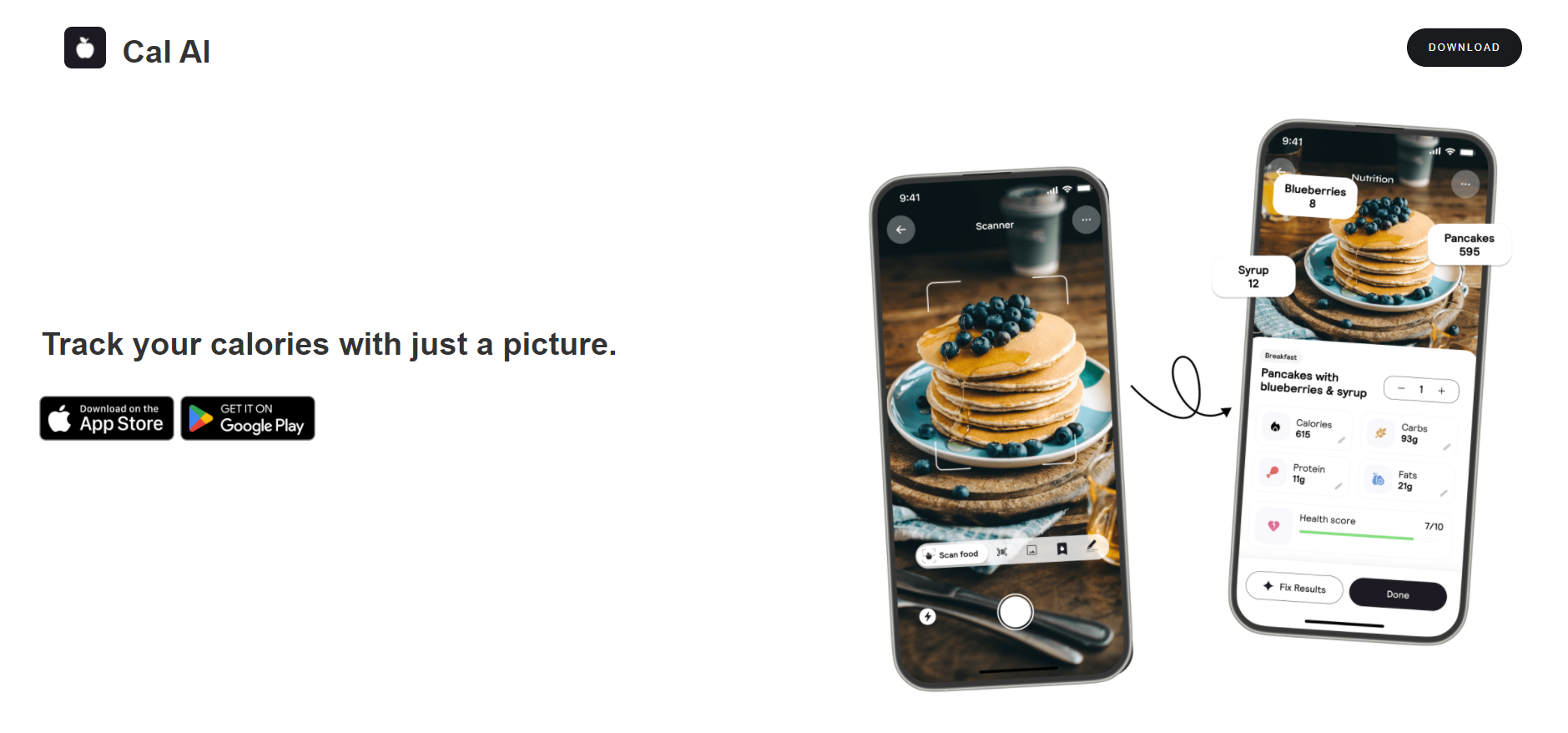

Cal AI ist eine KI-gestützte mobile App, die die Fotoanalyse verwendet, um die Kalorien- und Nährstoffzufuhr zu verfolgen.